Crear VMware ESX en Ravello

Ravello Systems es un servicio Cloud de gran calidad, que hace un tiempo fue comprado por toda una compañía como Oracle. Los VMware vExperts lo conocemos, porque llevan varios años regalándonos acceso a su plataforma para poder generar laboratorios.

Este año nos han regalado 1000 horas mensuales, así que intentaré sacarle provecho todo lo que pueda.

Hoy os quiero enseñar como crear un servidor ESX en modo Nested en la plataforma, por si os animáis a contratarlo, ya que si buscáis un servicio cloud de calidad, con servicio internacional, a buen precio, es una gran alternativa.

Lo primero que debemos hacer es entrar en la URL: https://cloud.ravellosystems.com e introducir nuestras credenciales:

![ravello-vmware-esx-1]()

Una vez que entramos, pulsamos en Library:

![ravello-vmware-esx-2]()

Subiremos una iso de VMware ESX en la sección Disk Images:

![ravello-vmware-esx-3]()

Pulsamos en Import Disk Image:

![ravello-vmware-esx-4]()

Descargamos la aplicación Ravello VM Import Tool:![ravello-vmware-esx-5]()

Instalamos la aplicación en nuestro ordenador:

![ravello-vmware-esx-6]()

Automáticamente se lanza un navegador que nos pedirá nuestras credenciales de Ravello:

![ravello-vmware-esx-7]()

Pulsamos Upload New Item:

![ravello-vmware-esx-8]()

Queremos cargar una ISO, así que seleccionamos la opción y así que pulsamos Start:

![ravello-vmware-esx-9]()

Elegimos y pulsamos Upload:

![ravello-vmware-esx-10]()

Esperamos que cargue:

![ravello-vmware-esx-11]()

Ya tendremos la ISO para poder utilizarla en nuestro ESX:

![ravello-vmware-esx-12]()

También generamos una Elastic IP Address desde el menú Library:

![ravello-vmware-esx-13]()

Elegimos la location que nos interese y pulsamos Create:

![ravello-vmware-esx-14]()

Tendremos la IP preparada en segundos:

![ravello-vmware-esx-15]()

Adicionalmente, creamos una Key Pairs desde también el menú Library. Nos generará un fichero PEM que se descargará automáticamente y nos permitirá conectarnos a las máquinas virtuales:

![ravello-vmware-esx-16]()

Generamos una Key de forma automática:

![ravello-vmware-esx-17]()

Ahora vamos a crear una aplicación desde el menú Applications -> Create Applications:

![ravello-vmware-esx-18]()

Le damos un nombre:

![ravello-vmware-esx-19]()

Vamos a la pestaña Canvas. Ravello ya tiene generada unas plantillas que utilizar. Arrastramos directamente la que se llama Empty ESX al centro:

![ravello-vmware-esx-20]()

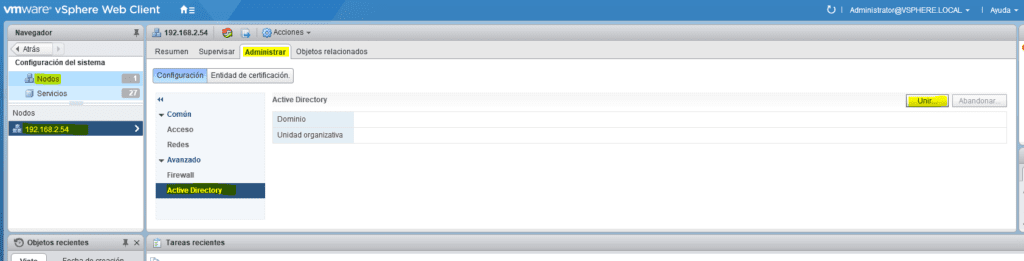

Lo primero que hay que hacer es ir a Disks –> Y mapeamos la imagen que hemos cargado en el DVD:

![ravello-vmware-esx-21]()

Seleccionamos la imagen del ESX:

![ravello-vmware-esx-22]()

Pulsamos Save:

![ravello-vmware-esx-23]()

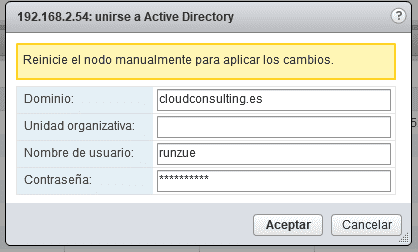

Pulsamos Publish:

![ravello-vmware-esx-24]()

Pulsamos Publish:

![ravello-vmware-esx-25]()

Esto si le llevará unos minutos, no muchos, tenéis que esperar a que desaparezca el reloj. Daros cuenta lo que tarda un proveedor de Internet en gestionar esto. Aquí no son más de 5 minutos, y genera automáticamente servidor DHCP, DNS, REDES, ROUTER,…muy impresionante:

![ravello-vmware-esx-26]()

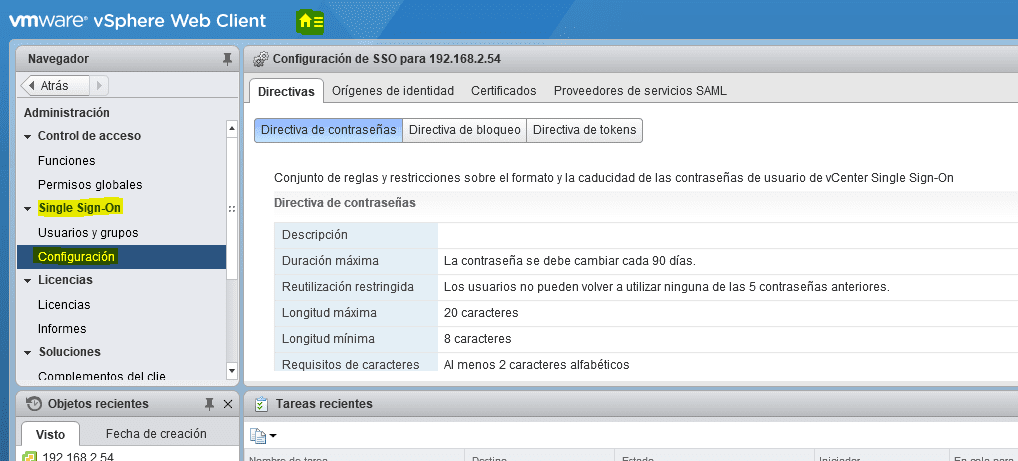

Veremos en la máquina la IP/Nombre para acceder desde fuera en la sección VM a Started:

![ravello-vmware-esx-27]()

Para realizar la instalación una arrancada, pulsamos Console:

![ravello-vmware-esx-28]()

Aquí no tiene mucho misterio, hacer una instalación común de ESX:

![ravello-vmware-esx-29]()

Disponéis de un mega teclado virtual para ayudaros con la instalación:

![ravello-vmware-esx-30]()

Desmapeamos la ISO una vez terminada la instalación. Acordaros en hacer Save e Upload y esperar a que termine:

![ravello-vmware-esx-31]()

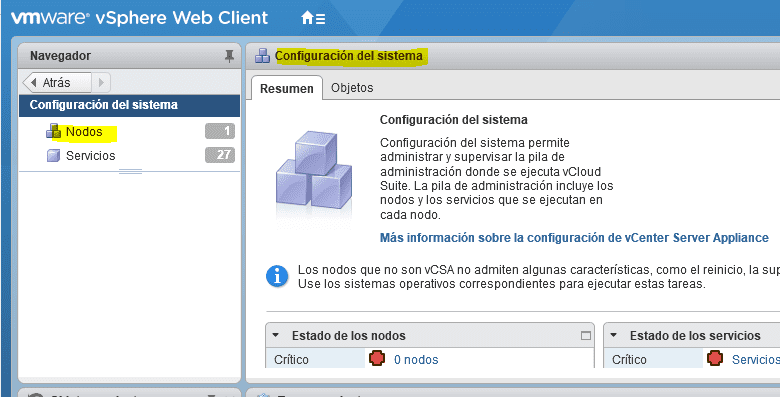

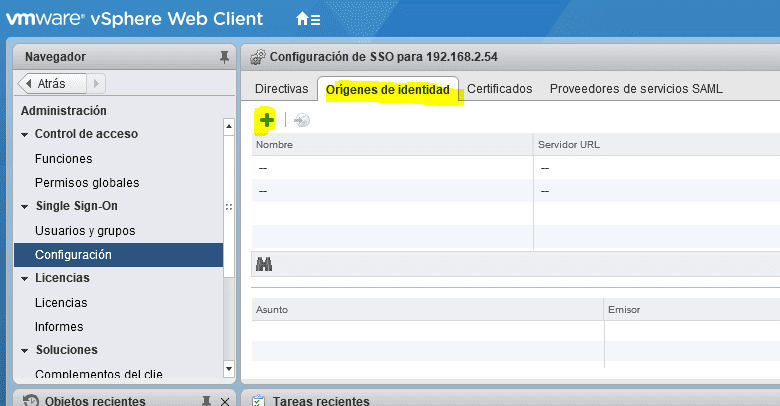

En la sección Network podéis ver el detalle de todas las redes, así como se ha generado también automáticamente una regla NAT en el FW para tener acceso externo:

![ravello-vmware-esx-32]()

Para poder gestionar el esx, a parte de SSH habilitamos el puerto 80. Vamos a Network –> VM –> Supplied Services:

![ravello-vmware-esxi]()

Añadimos los puertos 80 y 443:

![ravello-vmware-esxi-1]()

Y pulsamos Update para ejecutar los cambios:

![ravello-vmware-esxi-2]()

Y así ya tenemos acceso a la gestión desde fuera:

![ravello-vmware-esxi-3]()

Veremos qué cosas adicionales podemos hacer en próximas entradas.

La entrada Ravello VMware ESX se publicó primero en VMware Blog.